第一次看到他也是從2014年初登場中國好聲音第3季,一直以來,我都會多多少少觀注一下素人選秀節目 ,從台灣的星光大道,超偶,到後來大放異彩的中國選秀節目。其實那時聽到這首歌的時候,對他的聲音覺得特別,雖然有歡顏與貝加爾湖畔的比賽作品,但我其實就僅僅是有印象而已

初登場: 歡顏

VIDEO

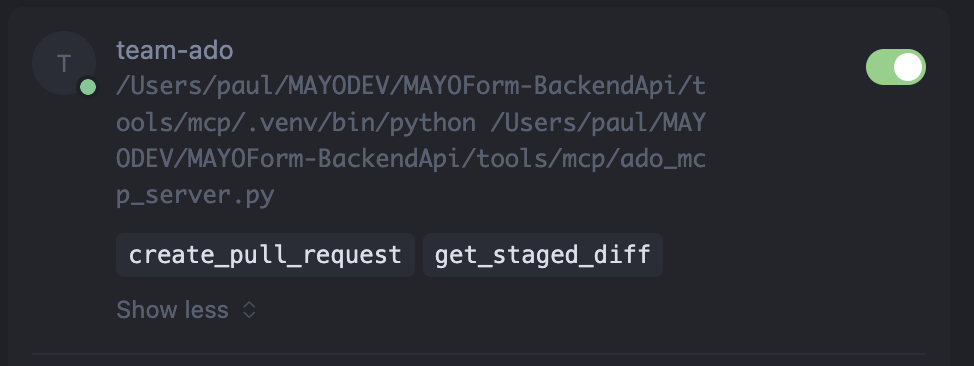

第二首-貝加爾湖畔 (被那英淘汰的名場面)VIDEO

真的對他驚豔的就是這個大魚美聲合唱版,以前有聽音樂劇跟世界三大男高音,其實我對這種美聲唱法就是有愛好~,所以我就開始 密切關注他,這時的他也默默已經有一些作品了。(動畫-大魚主題曲)

中國好聲音幫唱版本 ,唱到陳奕迅 都稱讚VIDEO

因為周深是烏克蘭音樂學院畢業的,以致於後來看到多首他的美聲的作品時 ,他的技巧也愈發成熟

以這兩首為例(2019~2020年左右)

歌劇魅影 – Think of MeVIDEO

貓- MemoryVIDEO

恰恰符合我對跨界美聲的審美,同時又具備有獨特性,在那時看來,根本就是一個鑽石(他勵志的故事又是另一段故事了)

他曾經說過,他特別珍惜並全力準備每一個表演的機會,因為他唯有這樣,才有機會有”下一個舞台”

有2020~2024年 ,幾乎可以看到他不斷的出現在各大晚會與典禮,也有無數的歌讓他唱,甚至一度戲稱勞動楷模

也是因為這樣,他開始被很多人聽到

香港明星們對周深的評價

VIDEO

那時因為幾個音綜開始嶄露頭角,我們的歌與他一起參演的周華健也 把對他的讚賞,帶到台灣,

連知名電台主持人光禹都開始挖起他的礦(看看下面的歌單就知道這個坑的深度),做了寶藏週記 一做也好幾年了

VIDEO

VIDEO

而其實這幾年 來周深的成長,從YOUTUBE的作品、能見度,都可以看的出來,他本身也很努力,他曾經說過 ,剛開始很多人對他的評價是∶「原來周深是一個男孩子,唱是唱的不錯,但若是做為一個女孩子,就顯著普通了」,他覺得很多人因為這樣 否定了他在音樂上下的努力。

然而他不畏酸言酸語,繼續憑實力與求新求變的勇氣,讓自己始終能保持,這是一個特別是他從不自信的轉變過來的,看著他就像自己的孩子一樣成長起來。

跟貝加爾湖畔 原唱 李健老師合作了一個即興舞台

VIDEO

出道十年 專訪,可以見得,他是一個心思非常細膩且正向的一個人

VIDEO

早期辛酸的經歷

VIDEO

VIDEO

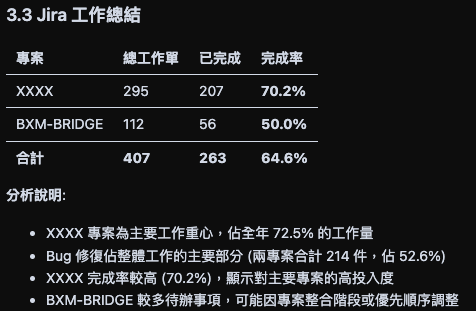

如今的維基百科寫道 : 周深是一位備受讚譽的中國男歌手,以其清亮溫柔的嗓音和多變的演唱風格著稱。自2014年參加《中國好聲音》第三季正式出道以來,他在音樂領域取得了眾多成就,以下是他的一些重要榮譽與貢獻:

🎤 音樂成就與代表作品

銷售成績與認證

首日銷售額

首週銷售額

累計銷量

平台認證

🌍 國際成就 以他的成長期,以我認識他的部分,我將 時間軸分類如下

跨界(融合美聲唱法) -> 我特別有興趣的

以出處來分的話,以下歌單大部分就是很單純的分法,沒有排名,大部分絕得要嘛是順耳,不然就是覺得 是值得一再品味的現場或錄音室 作品~

一看到JJ找他當佳賓,也算原了周深偶像的一個夢想,他們同台飆唱 真的滿感動的~因為這也是看到他被前輩認可了VIDEO

各大音綜時期

蒙面唱將猜猜猜

雪落下的聲音

VIDEO

《我真的受伤了》VIDEO

杨丞琳、周深VIDEO

《我是真的爱你》李宗盛VIDEO

聲入人心 我很愛聽音樂劇,這完美 發揮了他美聲VIDEO

貓- MemoryVIDEO VIDEO VIDEO

周深 王晰 月彎彎 二重唱

VIDEO

合作舞台 (他唱合音超強,超like他的二創加分作品)VIDEO

周深GAI周延合唱《玫瑰少年》 (原唱: 五月天or蔡依林)VIDEO

我們的歌VIDEO

周深 李克勤 – 《月半小夜曲》VIDEO

周深 李克勤 – 《天下有情人《我是真的爱你》》VIDEO

時光音樂會- 梁詠琪 – 花火VIDEO

時光音樂會- 阿杜 – AndyVIDEO

時光音樂會- 周杰倫 – 聽見下雨的聲音VIDEO

時光音樂會- 月光(原唱 : 胡彥斌 轉音一絕)VIDEO

原唱王菲 – 如願VIDEO

五月天- 好好VIDEO

起風了VIDEO

《歌手·当打之年》Singer 2020VIDEO

無問 – 原唱:毛不易VIDEO

《自己按门铃自己听》VIDEO

《大鱼》VIDEO

声生不息·家年华- 周深 汪蘇瀧 愛的供養 (原: 楊冪)VIDEO

声生不息·家年华- 周深 黃綺珊 歲月 (原: 王菲)VIDEO

声生不息·家年华- 周深 宋亞軒 桃花諾 (原: 鄧紫琪)VIDEO

声生不息·家年华- 周深 陳楚生 逆光(原 : 孫燕姿)VIDEO

舞台 2023 朴仔範、王嘉爾、Ella供他清唱大眠名場面

VIDEO

音樂緣計劃(新歌很多)VIDEO

合作版VIDEO

周深&周笔畅《孤独音乐家》VIDEO

二次元作品+翻唱 (他出圈前,在中國二次元界已經爆紅)VIDEO

《Unravel》 – 原唱 TK from 凛として時雨VIDEO

迪士尼合作作品VIDEO

星願 I’m a StarVIDEO

20201224周深Charlie Zhou Shen 九语版《Let It Go》VIDEO

OST電視原聲帶(古風劇)VIDEO

慶餘年 2-借過一下VIDEO

《願得一心人》(電視劇鶴唳華亭主題曲)VIDEO

《願》(電視劇錦衣之下主題曲)VIDEO

《若夢》(電視劇 夢醒長安 主題曲)VIDEO

陳情令《荒城渡》VIDEO

周深 + 鄭雲龍 -《曇花一現雨及時》(電視劇三千鴉殺主題曲)VIDEO

《明月傳說》(電視劇 風起霓裳 主題曲)VIDEO

Sword and Fairy《祈今朝》 | 《共鸣》VIDEO

【長歌行 The Long Ballad OST電視劇片尾主題曲】VIDEO

《相擁不放》(無損音樂連歌詞)(《白月梵星》影視劇主題曲)VIDEO

一晌 (電視劇《狐妖小紅娘月紅篇 Fox Spirit Matchmaker: Red-Moon Pact》片尾曲)VIDEO

曼陀 (《淮水竹亭》影视剧主题曲/片尾曲VIDEO

以上…太多了,遺珠之憾應該還有超過10首

OST電影原聲帶

《水形物語-奧斯卡金像獎最佳影片》(電影水形物語同名推廣曲)VIDEO

《問花》(電影 白蛇2:青蛇劫起 主題曲)VIDEO

張藝謀 – 《懸崖之上》(電影 懸崖之上 同名主題曲)VIDEO

《來不及勇敢》(電影昨日青空青春告白曲)VIDEO

《小美滿》【熱辣滾燙 YOLO OST 電影熱辣陪伴曲】VIDEO

電影《解密》中文版同名主題曲VIDEO

《流浪地球2》定义主题曲《人是_》VIDEO

OST電視原聲帶(現代劇主題區)

《消散人潮》【北上 Northward OST 電視劇片尾曲VIDEO

《雲邊的風箏》(又名《我們的王鶯鶯》VIDEO

《风吹过的晨曦》(玫瑰的故事情感主题曲)VIDEO

《幸福的故事》幸福裡VIDEO

人世間-光字片VIDEO

生活總該迎著光亮 (電視劇《喬家的兒女》主題曲)VIDEO

過客 (《以愛為營》電視劇主題曲)VIDEO

全英文歌VIDEO VIDEO

還有滿多現場 作品是英文歌

戲腔風格VIDEO

《易燃易爆炸》VIDEO

光亮 – 記錄片或實境節目 主題區VIDEO

手遊作品: 江湖3系列 第一部: 江湖緣起VIDEO

第二部: 江湖覓知音VIDEO

第三部: 《我,江湖》《一梦江湖》VIDEO

藝術歌曲 或合作舞台聯合國表演 – 《和平頌》VIDEO

周深+郎朗!钢琴+吟唱!《大鱼》+《Scarborough Fair 斯卡布罗集市》

VIDEO

周深、克萊德曼合作中國經典《梁祝 The Butterfly Lovers》

VIDEO

《月光爱人》南山流行音乐节

VIDEO

其他現場or翻唱 作品

唱给世界听 《随风》

VIDEO

鐵達尼號 My heart will go on (席琳迪翁)VIDEO

雪落下的聲音(神翻唱)VIDEO

《 問世間情是何物》 ( 詞:元好問 • 金朝)VIDEO

Unstoppable (原唱: SIA)VIDEO

FireVIDEO

身騎白馬(原唱: 徐佳瑩)VIDEO

《天堂島之歌》VIDEO

周深萨顶顶《左手指月》VIDEO

Zhou Shen/周深《與你同在》【い つ も 何 度 で も】[《千與千尋》主題曲日文版]VIDEO

自創曲-虛構 現場晚會首唱VIDEO

齐豫+周深 合唱《欢颜》 2024-2025跨年VIDEO

《我用所有报答爱》 – 譚盾 交響樂團VIDEO

《浮光》VIDEO

《我以渺小爱你》VIDEO

《花开忘忧》VIDEO

《卧龙吟》VIDEO

首張專輯 周深 Charlie Zhou【深的深】 全分享(10首歌)VIDEO

時隔七年,第二張個人專輯 反深代詞https://youtube.com/playlist?list=PLrlBqwsy1XpTJSap7VwatCdz6Fh0eUIYM&si=4rb5CSCdYfR12OEq